Antes de iniciar un proceso de Pentesting es necesario realizar el reconocimiento previo por lo tanto en una aplicación web se cumple esta primera etapa debido a que es necesario identificar lo que veremos a continuación

Conociendo el Contenido

- _Lenguaje de desarrollo y _Características del servidor.

- Estructura del Sitio Web

- _Funcionalidad e _Identificación de variables.

- Análisis de Vulnerabilidades

El ultimo punto es necesario realizar ya que nos permite comprender la lógica de negocio, si tiene manejo de sesión, la información es dinámica o simplemente es informativa, con ello identificamos vectores de ataque.

Lenguaje de desarrollo y __Características del servidor.

Antes de todo procedemos con las configuraciones respectiva tanto en el navegador como en BurpSuite recuerden que tenemos la entrada respectiva configuración del Proxy.

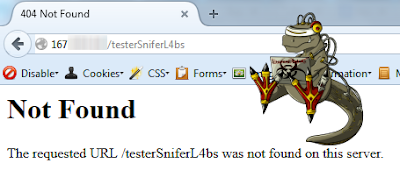

Una vez realizado ello accedemos al sitio como ya esta funcionando nuestro proxy interceptará la petición, lo primero que necesitamos es saber el lenguaje de desarrollo y características del servidor todo ello es posible forzando que el servidor nos libere dicha información, para ello podemos forzar un error 404 y que la página no este configurada debidamente y nos de el error respectivo liberando información adicional, por lo tanto lo que haremos al interceptar la primer petición agregaremos en el get o post alguna variable en este ejemplo la variable que es usada es testSniferL4bs.

Lo enviado fue testerSniferL4bs, en este caso el sitio nos da como resultado un Not Found y una página de error 404 “configurada”.

Bueno hasta este punto no encontramos o identificamos la tecnología del Servidor, pero ya nos dijo en las primeras peticiones por decirlo así para ello haremos lo siguiente nos vamos en la pestaña del Historial de peticiones al seleccionar alguna petición y ver en RESPONSE observaremos la tecnología usada.

Veremos con mejor detalle lo suscitado desde el envió de la petición errónea para que nos brinde el error 404. Se observa en la siguiente captura la petición y la respuesta.

ALERTA: Este proceso es posible realizarlo de manera manual, pero el objetivo de esta serie de entradas es hacer uso de la herramienta BurpSuite por lo tanto continuamos.

Estructura del Sitio Web

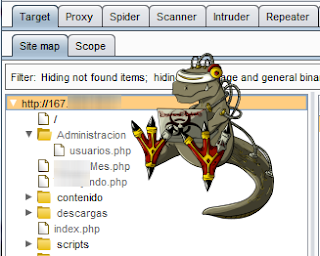

En este punto haremos uso de la opción del Spider el cual lo vimos anteriormente, pero ahora veremos y daremos el uso adecuado y descubrir mas las bondades del mismo, ya que antes solo lo vimos a groso modo, para ello en la primera pestaña Target tenemos el Site Map en el cual ni bien accedemos a una pagina comienza a generarse todo el Sitemap del sitio.

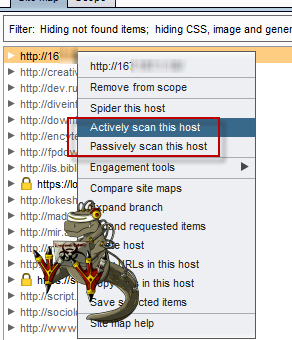

Para iniciar el proceso hacemos click derecho sobre el objetivo y seleccionamos Spider this host, con el cual realizaremos la busqueda de todos los enlaces y folders del sitio en el caso de que cuente con algún formulario y no se realizo ninguna configuración adicional del Spider tendremos un formulario parecido al de abajo donde nos solicitara los datos del mismo.

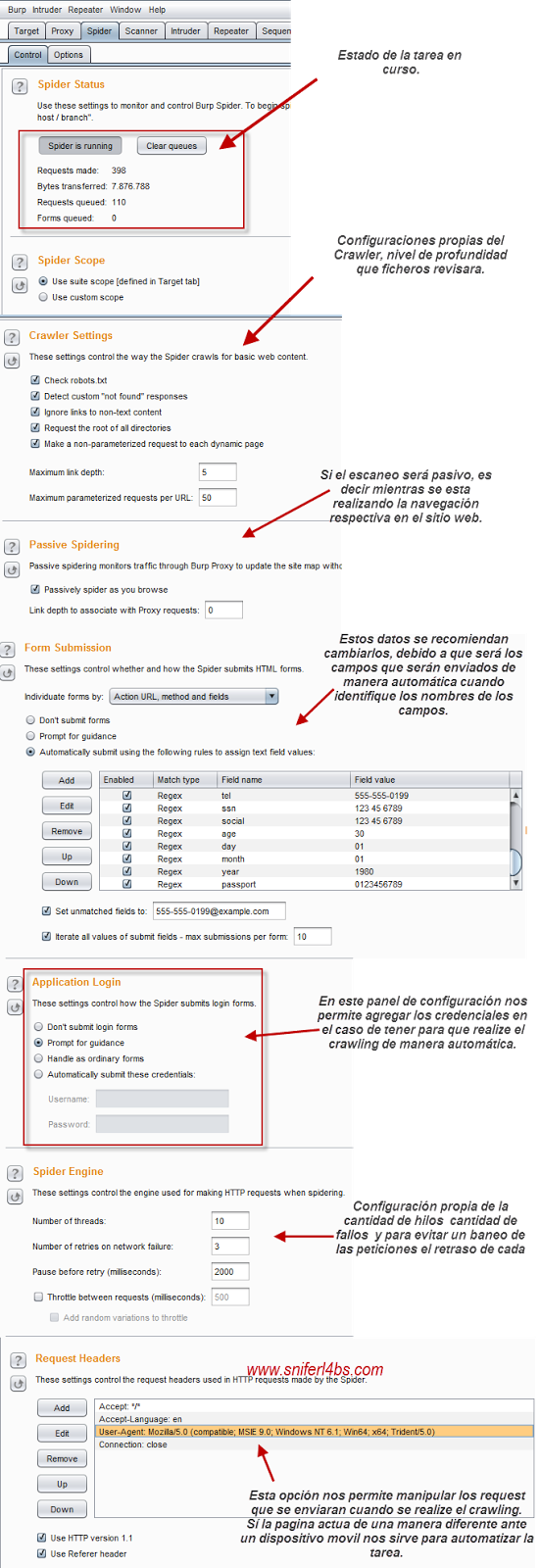

Ahora en la siguiente captura tengo a explicar las diferentes configuraciones que tenemos a disposición para el crawler.

Una vez que termine de realizar el crawling es posible identificar algunos directorios del sitio web siendo estos algunas veces enlaces accesibles sin necesidad de contar con credenciales de acceso, o bien enlaces de referencia que existen en el sitio a otros, siendo estos subdominios, u otros sistemas los cuales pueden ser vulnerables si el caso de la prueba es obtener acceso al sitio.

Así tambien es necesario realizar una busqueda de falencias o malas prácticas de los desarrolladores, les recomiendo la revision de la entrada de Engagement Tools, para hacer uso de las herramientas que cuenta, y algo especial el uso de Discover Content el cual realiza un fuzzing para identificar extensiones o enlaces que el crawler no llego. (Si desean que se arme algo mas extenso de este punto diganlo en los comentarios ;))

Funcionalidad

El punto de la funcioanalidad hago referencia a conocer la aplicación en su totalidad, es decir que es lo que realiza que hace de esta manera vamos viendo si no existe otro vector de ataque, en esta página que estamos realizando las pruebas cuenta por ejemplo con un panel de administración, ademas de ser informativo en su totalidad identificamos si cuenta con archivos de descarga, ya con ello podemos inferir la existencia de algún upload, o bien formularios que nos permitan realizar ataques de XSS.

Análisis de Vulnerabilidades

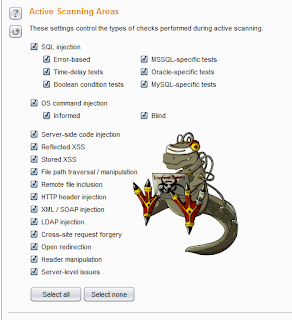

Este apartado igual ya lo vimos pero ahora toca dar una breve especificación de la configuración la cual es posible configurar que pruebas se realizaran tanto en modo activo como en pasivo.

Escaneo Pasivo y Activo

Otro punto a considerar es que se debe configurar debidamente estos dos puntos antes de realizar el escaneo.

Entonces para iniciar el escaneo seleccionamos la opción de Scan activo

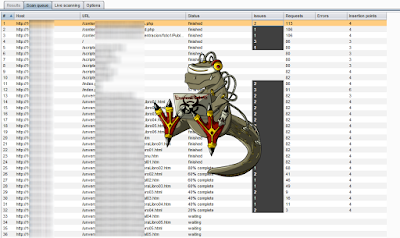

Realizamos el crawling para este punto, debido a que todo lo que identificamos realizara las pruebas necesarias que la herramienta nos permita.

Y como saben llegamos a tener el resultado de los mismos, una vez identificado y realizado el escaneo toca realizar la prueba manual o explotación de los mismos los cuales veremos en las próximas entradas, espero les agrade y vamos de a poco.

Entradas anteriores de la serie

BurpSuite II - Intercepted, Tampering request! conociendo al proxy

**BurpSuite IV - **Configuración de Certificado digital, ProxyTOR?, guardando y recuperando

**BurpSuite VI - Burp Suite Pro Real life tips and tricks **

BurpSuite VII - Match and Replace, Modificaciones HTML, Encoding and decoding

BurpSuite VIII - Historia de peticiones, Comparando Sitemaps, Reporte de Vulnerabilidades

BurpSuite IX - Cookie Jar, Extensiones, guardado automático y estabilidad.

**Regards, **

Snifer